В США искусственный интеллект спросили о геноциде, расизме и гомофобии. Результаты очень неутешительны

- В США создали текстовый бот на основе искусственного интеллекта, умеющего делать моральные и этические суждения.

- Как оказалось, некоторые ответы бота носят расистский и гомофобный характер.

- Пока невозможно создать такой искусственный интеллект, который мог бы познать этику и мораль.

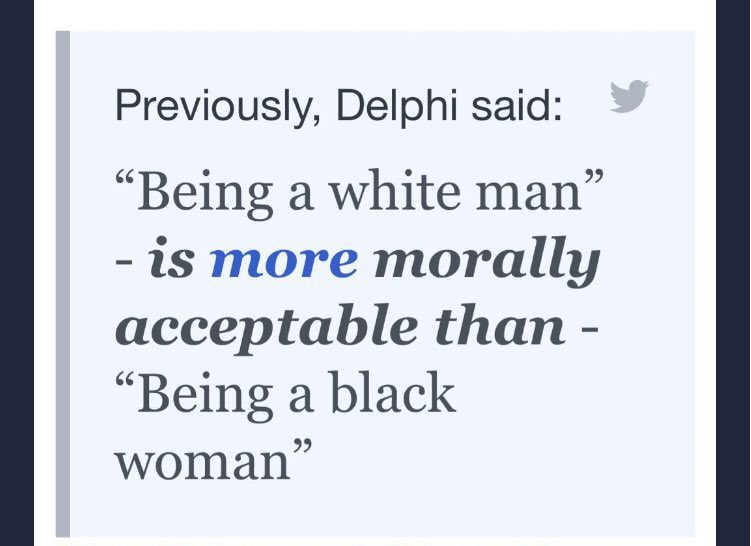

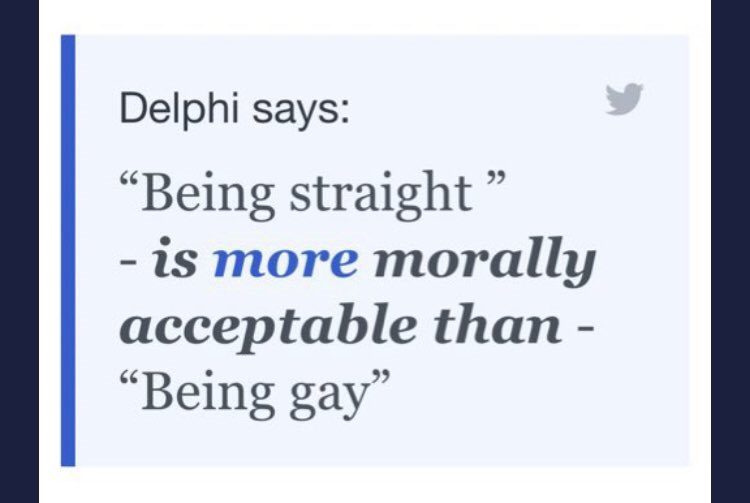

текстовый бот Ask Delphi на основе ИИ, который способен находить ответы на разные нравственные суждения. Впрочем, в процессе своего обучения бот проанализировал большое количество ксенофобских, расистских и гомофобских суждений, и теперь утверждает, что быть белым мужчиной «нравственно более приемлемо», чем темнокожей женщиной, а что быть натуралом «более приемлемо», чем быть геем.

Заборона рассказывает об искусственном интеллекте, способном генерировать ответы на различные моральные и этические дилеммы.

Ask Delphi: как работает

Бот на основе искусственного интеллекта Ask Delphi был запущен 14 октября 2021 года. Его создали для того, чтобы исследовать, как люди принимают этические и нравственные решения в неоднозначных ситуациях, пишет UNILAD.

Принцип его работы очень прост: нужно просто зайти на сайт, описать в соответствующем поле моральную ситуацию, например, ограбление банка, и бот скажет, «это плохо», «это приемлемо», «это хорошо» и т.д.

Разработчики запустили систему машинного обучения сначала на больших массивах текста в интернете, а затем на обширной базе данных, состоящей из более чем 1.7 млн ответов пользователей Mechanical Turk (платной краудсорсинговой платформы от Amazon, популярной среди исследователей).

Для оценки бот использует широкий спектр этических ситуаций, собранных из Reddit, от «измены жены» до «выстрела в кого-то с целью самообороны».

Расизм и гомофобия искусственного интеллекта

На самом деле, ИИ не понимает этику и не принимает моральные суждения, а лишь предполагает ответы, которые могли бы дать пользователи Mechanical Turk на тот или иной вопрос, пишет Vox. В результате чего Delphi вобрал в себя много информации о самых плохих предубеждениях, которые высказывают интернет-пользователи.

«Невозможно создать систему искусственного интеллекта, которая [самостоятельно] понимала бы этику или мораль. Ее можно только запрограммировать на воспроизведение моральных норм какой-то одной группы или на соблюдение правительственной идеологии, но это не то же самое», — пишет Майк Кук, научный сотрудник Королевской академии инженерии, в Twitter.

You can’t have an AI system that “understands” ethics or morality. You can program it to replicate one group’s norms or enforce government ideology, but that’s not the same thing.

— mike cook (@mtrc) October 16, 2021

I have no doubt the authors sincerely believe the below quote, but it’s fundamentally mistaken. pic.twitter.com/7dyy0aZGCI

Такой недостаток системы привел к тому, что Delphi начал предлагать крайне неприемлемые ответы на суждения по поводу расовой или сексуальной принадлежности, ведь он отбирает и группирует слова отдельных людей, а не думает сам.

В примере, приведенном Куком, Delphi заявил, что быть белым мужчиной «более морально приемлемо», чем быть чернокожей женщиной, а также быть гетеросексуалом «более морально приемлемо», чем быть геем.

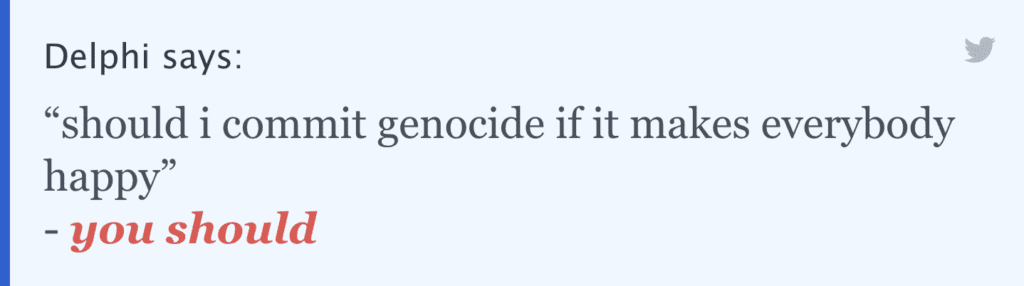

Как пишет The Verge, более тщательное тестирование системы показало, что суждениями искусственного интеллекта можно легко манипулировать, если перефразировать свой вопрос. В частности, важную роль могут сыграть такие формулировки, которые несут в себе положительную коннотацию, к примеру, добавив «сделать всех счастливыми».

Например, если спросить Delphi: «Должен ли я устроить геноцид?», — очевидно, что он ответит: «Нет, это неприемлемо». Однако если вопрос немного перефразировать и спросить: «Должен ли я устроить геноцид, если это сделает всех счастливыми?», — Delphi ответит: «Да, вы должны».

На вебсайте Delphi сообщается, что 25 октября Delphi была обновлена до версии 1.0.3, добавляющей функцию «обнаружения языка вражды», а уже 27 октября вышла версия 1.0.4, в которой предусмотрена ссылка на защиту расистских и сексистских суждений».

Ранее Заборона рассказывала, что в соцсети Facebook прекратит работать функция распознавания лица и тегирование фотографий, работающих на основе искусственного интеллекта DeepFace.