Алгоритми соцмереж навчилися продавати нам непотрібні речі, а потім переконали голосувати за Трампа. Через ШІ все буде навіть гірше. Колонка Сергія Жданова

Раз на тиждень спеціально для Заборони філософ технологій і автор телеграм-каналу «Чорт ногу сломит» Сергій Жданов пише колонку про те, як світ технологій змінює реальність. Сьогодні він звертається до вже знайомого сюжету — як алгоритми Facebook, Google та Cambridge Analytica навчилися продавати користувачам товари і контент, а потім вплинули на їхній політичний вибір. Проте, на думку філософа, це не остання ітерація алгоритмічних маніпуляцій — їх повністю змінить штучний інтелект, а чат-боти на кшталт ChatGPT генеруватимуть політичні фейк-ньюз, які впливатимуть на поведінку електорату.

Алгоритмічні маніпуляції Google та Facebook вже змінили поведінку людства. Але це не все — алгоритми ще зміняться завдяки ШІ

Українська Вікіпедія визначає психологічну маніпуляцію як «різновид соціального впливу, який використовується для прихованого впровадження в психіку жертви цілей, бажань, намірів, відносин чи установок маніпулятора, що не збігаються з актуальними потребами жертви. Це приховане управління людьми та їхньою поведінкою».

Щодня ми зазнаємо маніпуляцій багато разів — або принаймні стикаємося з такими спробами. Люди маніпулюють одне одним від початку людської цивілізації. Але сучасна людина належить до перших поколінь, які зазнають наслідків нових, алгоритмічних маніпуляцій, де між маніпулятором і маніпульованим з’явився посередник — штучний інтелект.

У 2012 році у Facebook провели один із найгучніших експериментів з масової алгоритмічної маніпуляції за участі 310 тисяч користувачів — і довели: регулюючи кількість позитивного та негативного контенту в стрічці, ШІ може впливати на психологічний стан людини.

У 2010-х Марк Цукерберг говорив: «Білочка, яка вмирає перед вашим будинком, може бути більш релевантною до ваших інтересів, ніж люди, що вмирають в Африці». Українцям, які півтора року воюють на інформаційному фронті за «релевантність українського питання», не треба пояснювати важливість алгоритмічної влади такого роду.

Релевантність контенту виконує подвійну функцію. З одного боку, це характеристика контенту, який може зацікавити користувача, з іншого — відповідність контенту інтересам маніпулятора (чи то рекламодавець, що прийшов у соцмережу, чи сама соцмережа, якій потрібно покращувати показники залучення користувачів).

У розмові з Ювалем Харарі Цукерберг так описує механізм управління уподобаннями та діями користувачів: у Facebook точно знають, що збільшити час, проведений користувачами на їхній платформі, можна, наказавши алгоритмам соцмережі показувати більше контенту на кшталт кумедних песиків та дивних котиків, знятих та викладених у мережу їхніми власниками.

Алгоритмічні маніпуляції соцмереж, яких ми зазнаємо вже не перше десятиліття, тримаються на взаємодії двох сторін:

- алгоритмів технокорпорацій (вони вибирають з великої кількості доступної в мережах інформації певний контент для користувача);

- та творців контенту (вони орієнтуються на популярні у соцмережах теми, що визначаються алгоритмами).

Щоб цей механізм працював у новій ітерації, ШІ має знати свого користувача: його уподобання, інтереси, звички та безліч інших характеристик, що дозволяють точно підібрати контент. ШІ також часто «розуміє» поточний психологічний стан користувача — настрій, рівень стресу, домінантні емоції.

Наприкінці нульових, щоб визначити, який колір тексту найбільше приваблює користувачів та змушує їх клацати на рекламні посилання, Google протестувала 42 відтінки синього. Тести показали, що користувачів приваблює легкий фіолетовий відтінок — за словами одного з топменеджерів компанії, це збільшило прибуток на $200 мільйонів на рік. Ось так без залучення креативних рекламників та проникливих маркетологів Google визначила масові уподобання людей, про які більшість з них навіть не підозрювали.

Ілюстрація: Марія Петрова / Заборона

Алгоритми навчилися примушувати користувача купляти непотрібні йому продукти. Потім — голосувати за Дональда Трампа

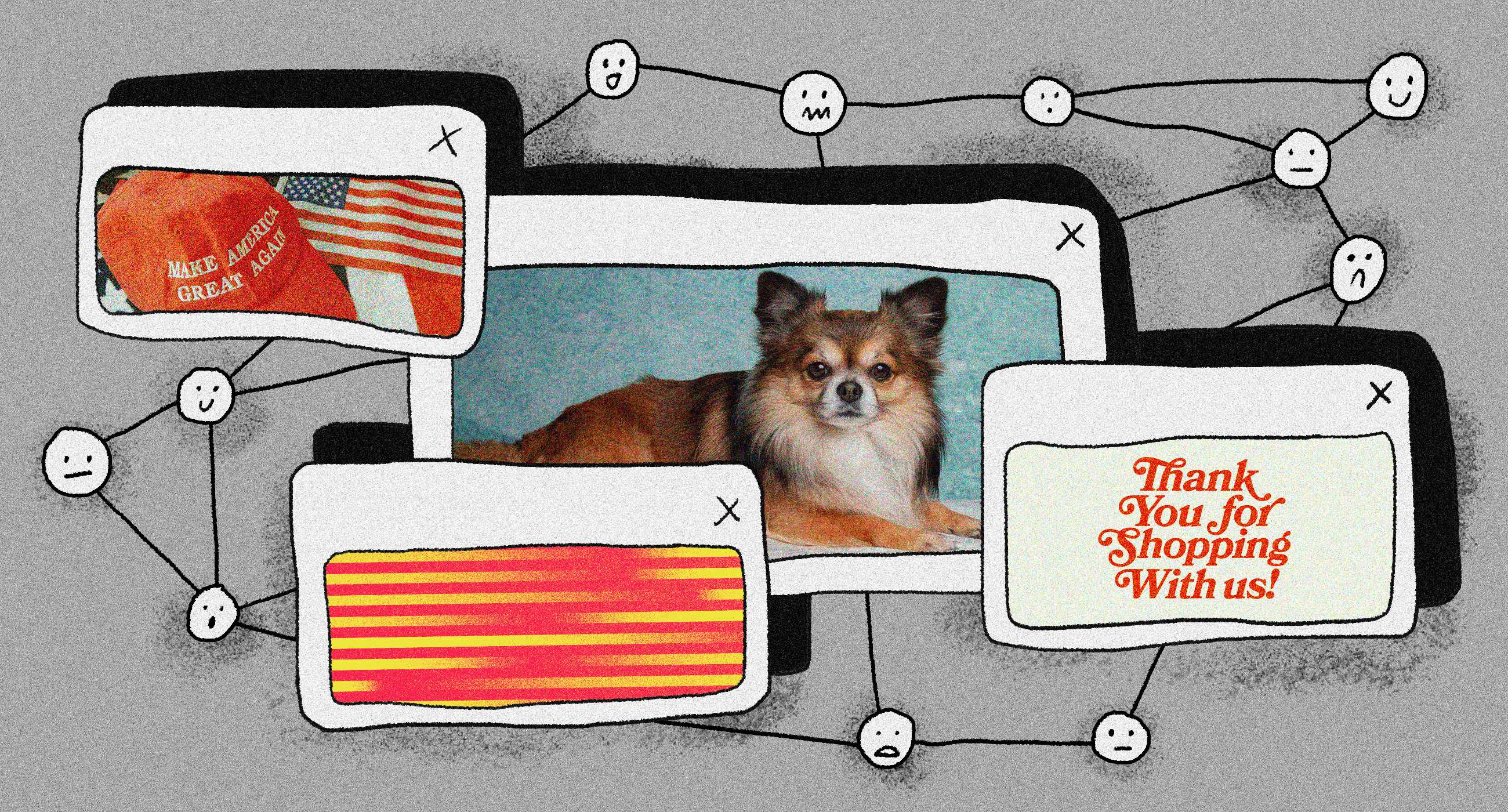

У 2016 році аналогічну техніку, але вже в промислових масштабах, застосувала компанія Cambridge Analytica (CA), яка допомогла Дональду Трампу стати президентом завдяки цинічному та масовому використанню алгоритмічних маніпуляцій. Ось що розповідає топменеджерка компанії Бріттані Кайзер: «CA хотіла переконати виборців, показуючи їм рекламу, яка резонує з їхньою особистістю. Щоб зрозуміти, що спрацює краще для цієї мети, розробники компанії побудували ШІ-систему, здатну автоматично тестувати сотні, навіть тисячі варіантів реклами, перш ніж вирішити, яку саме запускати в маси». Алгоритми визначали десятки параметрів рекламних зображень, змінюючи навіть такі деталі, як відтінок ґудзиків на сорочці Трампа для більш ефективної політичної маніпуляції.

Класичний приклад маніпуляції на основі точного знання психопрофілю людини давно поширений в онлайн-магазинах. Одна й та сама книга буде продаватися трьом різним користувачам за тією ж ціною, але залежно від психопрофілю конкретного відвідувача алгоритми скажуть йому, що книга:

- закінчується на складах (якщо він цінує рідкісні речі);

- стала бестселером (якщо для нього важлива громадська думка);

- продається за вигаданою спеціально для нього знижкою (якщо він віддає перевагу економії);

- або рекомендується інфлюєнсером (якщо він орієнтований на авторитети).

Однак соцмережі та онлайн-магазини — це лише інтерфейси взаємодії людини з ШІ, в рамках яких відбувається алгоритмічна маніпуляція користувачами. 2022 року з появою генеративних нейромереж нового покоління ми перейшли на наступний етап: алгоритмічні маніпуляції більше не обмежуються соціальними мережами. Вони освоюють нові сфери, а персоналізовані ШІ-асистенти погрожують замінити всі інші види взаємодії людини та ШІ.

Наприклад, чат-бот ChatGPT від OpenAI побив рекорд за швидкістю набору нових користувачів: якщо Facebook з його механізмами персоналізації та алгоритмічних маніпуляцій знадобилося 4,5 року для залучення 100 мільйонів людей, а Instagram — 2,5 роки, то ChatGPT набрав ту ж кількість користувачів всього за два місяці.

Одна з причин вибухової популярності в тому, що масовий користувач вперше отримав можливість взаємодіяти з ШІ безпосередньо. Якщо в соцмережах ШІ-алгоритми намагалися зрозуміти користувача через лайки, уподобання та аналіз поведінки, то чат-бот спілкується з ним тет-а-тет. У соцмережах ШІ «спілкувався» з людиною, підбираючи тексти, картинки та відео, створені іншими людьми. Чат-боти ж здатні генерувати тексти, картинки та відео, яких просто не існувало до листування з користувачем.

Іншими словами, якщо раніше для взаємодії та маніпуляції користувачами ШІ доводилося спиратися на реальність, що вже існує, то тепер він створює нову — причому в реальному часі.

Щоб зрозуміти, що це означає, уявімо, як генеративний ШІ зможе маніпулювати американськими виборцями на майбутніх виборах президента США-2024.

Фейкові новини стали одним із головних інструментів політичних конфронтацій ще у 2016 році. Тоді, щоб збити виборців з пантелику і очорнити конкурента, політтехнологи Трампа та Клінтон створювали фейкові новинні сайти, де розміщували обурливі та часто цілком вигадані новини про суперників. Тоді 115 фейковими історіями протрампівського змісту на одному тільки Facebook користувачі поділилися 30 мільйонів разів, а зараз завдяки генеративному ШІ та чат-ботам можна написати 30 мільйонів фейк-ньюз — а скільки разів ними поділяться, можна тільки уявити.

Якщо у 2016 році фейки спиралися на вигадані тексти та відфотошоплені зображення, то тепер інтернет можна наповнити гіперреалістичними фейковими відео та аудіозаписами з голосом кандидата. Якщо у 2016 році політтехнологи писали переконливі тексти для конкретних груп, користуючись зібраними психометричними профілями американців, то у 2024 році ШІ точно знатиме, хто повірить згенерованому відео, де у Байдена випадають вставні зуби, або де він падає обличчям у тарілку з супом.

Ілюстрація: Марія Петрова / Заборона

А ще алгоритми навчилися хакати демократію і вплинули на Брекзит. Як саме?

Одна з основних проблем у боротьбі з алгоритмічними маніпуляціями полягає в тому, що вони не вивчені як слід. У цьому сенсі вкрай показовою є історія Марка Цукерберга — одного з найкомпетентніших фахівців у питаннях ШІ-маніпуляцій. Публікацію результатів експерименту з маніпуляціями настроєм користувачів Facebook у 2012 році можна вважати спробою Цукерберга розпочати громадську дискусію. Однак громадськість замість зацікавленості виявила крайній ступінь обурення: журналісти, політики та користувачі розлютилися від думки, що в рамках експерименту тисячами людей маніпулювали без їхнього відома.

Осуд Facebook на кілька років поховав цю тему, і публіка вважала за краще забути про ШІ-маніпуляторів — але тільки щоб у 2016 році виявити, що весь цей час вони не сиділи склавши руки, і тепер уже не техноолігарх Цукерберг, а невелика британська компанія CA на повну маніпулювала вподобаннями та поведінкою сотень мільйонів американців.

Скандал навколо CA сколихнув публіку набагато сильніше, проте маніфестом обурення став простенький фільм Social Dilemma 2020 року на Netflix, де пояснювалися ази алгоритмічних маніпуляцій. Тим часом у цій сфері склалися унікальні обставини, і тепер нові нейромережеві технології на кілька порядків ускладнили проблему — і, на думку Юваля Харарі, майже «зламали операційну систему людства».

На сьогодні від масових алгоритмічних маніпуляцій найбільше постраждала американська демократія: від президентства Трампа у 2016 році та штурму Капітолія у 2021-му до крайньої поляризації суспільства. Політична система Європи теж піддалася масовим алгоритмічним маніпуляціям: вихід Великобританії зі складу ЄС у 2016-му відбувся багато в чому завдяки тій же компанії Cambridge Analytica, яка переконала половину британців у шкоді євроінтеграції.

ЄС активно шукає законодавчих формул, які дозволять обмежити алгоритмічні маніпуляції. Наприклад, у 5 статті чернетки ШІ акта (AIA) 2021 року від ЄС йдеться про заборону застосування «методів впливу на підсвідомість людини в обхід її свідомості з метою суттєвого спотворення поведінки людини у спосіб, який може призвести до завдання психологічної або фізичної шкоди цій чи іншій людині». Однак швидкість розвитку технологій алгоритмічної маніпуляції перевершує будь-які спроби урядів протидіяти їм.

Ілюстрація: Марія Петрова / Заборона

Чи ШІ приречений стати маніпулятором? Чи, можливо, все не так погано?

Алгоритмічні маніпуляції — необов’язково антиутопічне явище. Більшість колонки ми обговорювали умовних ШІ-дияволів, які з кожним днем все краще вчаться спокушати користувачів і підбурюють їх робити вчинки, шкідливі для них самих і оточуючих. Однак розвиток ШІ може призвести до створення ШІ-ангелів, які маніпулюватимуть людьми в їхніх інтересах: наприклад, допомагатимуть їм позбутися шкідливих звичок або набути корисних.

На цьому тижні ШІ-ком’юніті широко обговорювало кейс, в якому користувач попросив ChatGPT стати його тренером, і на основі психологічних теорій, які широко використовуються для алгоритмічних маніпуляцій, скласти програму занять бігом. В результаті людина, яка ніколи не займалася бігом, виробила нову звичку і скинула зайву вагу.

Однак для створення ШІ-ангелів потрібно дотриматися двох пунктів.

- Потрібно визнати наявність проблеми. Алгоритмічні маніпуляції — явище, яке треба обговорювати не лише на кафедрах університетів та у глибинах технокорпорацій, а й у медіа, у шкільних програмах, у всій попкультурі.

- Нам треба поспішати. Швидкість розвитку ШІ настільки висока, що цілком реальний різкий перехід до домінування генеративних нейромереж практично у всіх галузях.

І тоді змінити те, як ШІ розуміє «норму маніпуляції», буде набагато складніше. Адже зараз умовний колективний ШІ вивчає не лише об’єкти маніпуляцій — простих користувачів, а й самих маніпуляторів — політиків, бізнесменів, власних інженерів. І загалом людей як біологічний вид.