Наприкінці травня 2024 року OpenAI випустила перший у своєму роді звіт про створену за допомогою штучного інтелекту дезінформацію. Протягом весни компанія виявила та заблокувала пʼять прихованих кампаній впливу, що проводили державні та приватні акаунти з Китаю, Ізраїлю, Росії та Ірану. Зловмисники використовували генеративний ШІ OpenAI для створення та поширення пропаганди у соціальних мережах.

Порнографія, пропаганда, пранки, шахрайство та фейки — все це зараз активно створюється за допомогою нейромереж або так званого генеративного штучного інтелекту. Згенерована дезінформація представлена у всіх можливих форматах: відео, зображення, аудіо та текст. Ще ніколи обман не був таким переконливим і таким простим у створенні.

Як розпізнати дезінформацію, створену за допомогою ШІ? Як убезпечити себе, застосовуючи критичне мислення? Чи взагалі є законодавство, здатне захистити користувачів від фейків? Про все це — в матеріалі партнерів Заборони Factcheck.kz.

Нейромережі та небезпека

Згідно зі звітом OpenAI, протягом трьох місяців російські кампанії критикували США, Україну та країни Балтії, зокрема, використовуючи ChatGPT для створення Telegram-бота. Актори (примітивна одиниця, яка одержує повідомлення та робить на прості обчислення їх основі) з Китаю виробляли контент різними мовами для Х та Medium. Іранські актори генерували цілі статті проти США та Ізраїлю, перекладаючи їх англійською та французькою. Ізраїльська фірма Stoic створювала фейкові акаунти та різний контент, що звинувачував в антисемітизмі американських студентів, які протестують на захист Палестини.

Будь-яку перспективну технологію людство віртуозно вміє перетворювати на зброю — і нейромережі не стали винятком. ШІ демонізувався здавна: у численних фантастичних сюжетах він виходив з-під контролю та ставав одним з головних антагоністів цивілізації.

Утім, це не заважало IT-гігантам активно інвестувати в штучний інтелект, а вченим — розвивати цю сферу. Вже зараз видно, що генеративний ШІ став революцією та змінить цілі галузі.

Задовго до появи Midjourney, ChatGPT та інших систем на основі генеративного штучного інтелекту фахівці передбачили, що разом з розвитком зростатиме і загроза, яку ця технологія несе для людства. Але тоді для багатьох ці попередження звучали як обіцянки про повстання машин у стилі «Термінатора».

Однак зараз можна констатувати: використання генеративних моделей як мінімум для створення дезінформації є цілком реальною загрозою.

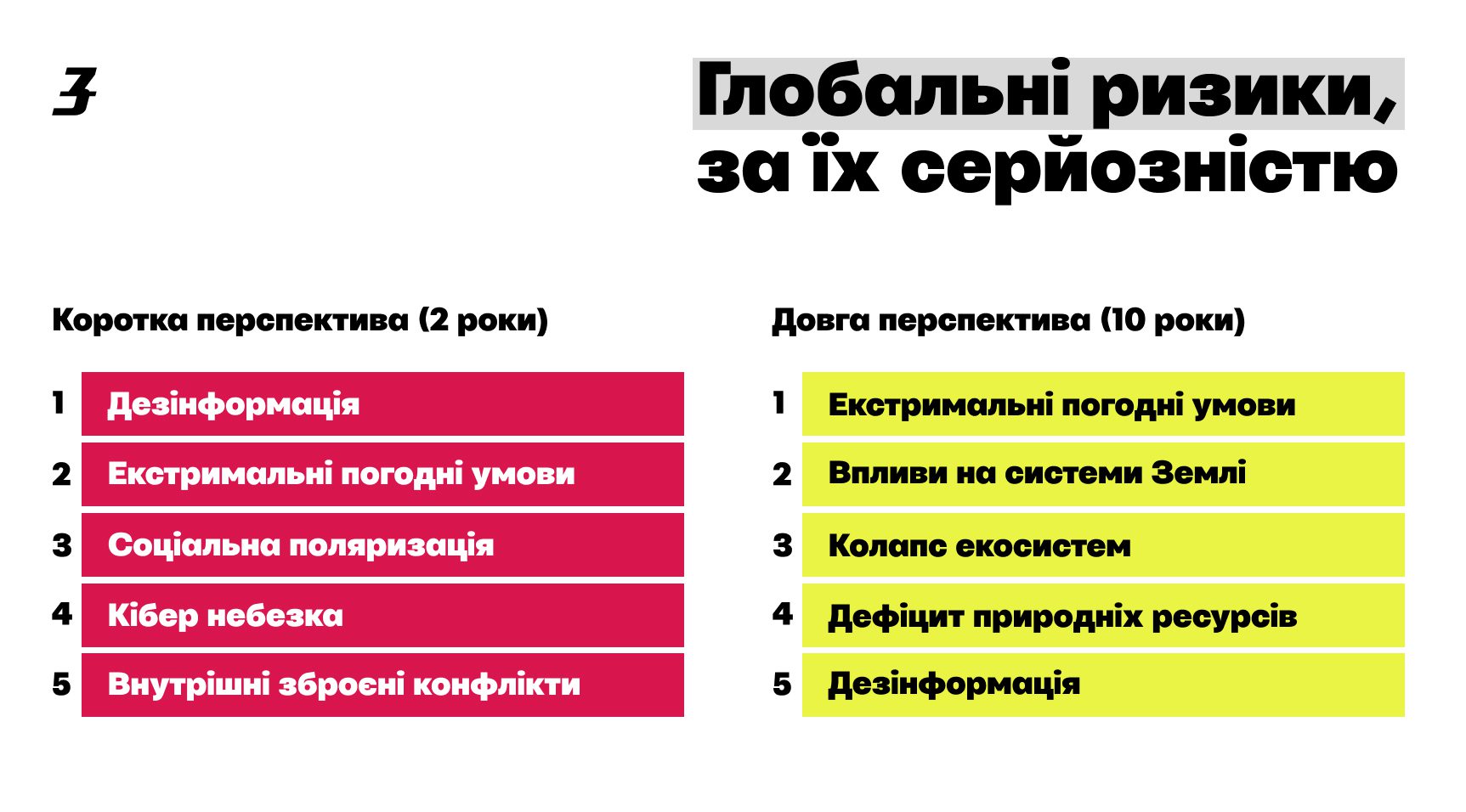

Аналітики Всесвітнього економічного форуму у 2024 році назвали дезінформацію, створену за допомогою ШІ, найсерйознішою загрозою світовій спільноті у короткостроковій перспективі. На їхню думку, передові програми посилюють поширення хибної інформації, яка загрожує підірвати демократію і поляризувати суспільство та є головним безпосереднім ризиком для світової економіки.

Інфографіка: Катерина Круглик / Заборона. Дані: звіт WEF.

Загрожує не ШІ, а людина

Говорячи про інформаційні ризики, які становить генеративний штучний інтелект, звичайно, ми маємо на увазі не самі програми, а користувачів. Досить швидко шахраї, пранкери та пропагандисти зрозуміли, що за допомогою нейромереж можна досягати своїх цілей швидше й ефективніше.

В результаті замість довгого та копіткого монтажу тепер можна легко створювати відео- та аудіодипфейки зі знаменитостями й політиками. Шахраї вже використовують згенеровані відео для реклами своїх схем і навіть виманюють великі суми у людей у реальному часі за допомогою відеодзвінків.

Але ще небезпечніші дипфейки, які використовуються для політичних маніпуляцій. З їхньою допомогою можна дискредитувати будь-якого опонента. Ось кілька прикладів:

- пранк антивоєнних російських активістів;

- дипфейк-відео з президенткою Молдови Маєю Санду про майбутню мобілізацію в країні;

- аудіодипфейк з голосом мера Лондона, в якому той закликає відкласти захід на згадку про жертв Другої світової війни на користь пропалестинського маршу. Поширення останнього фейку мало не призвело до масових заворушень.

Пропагандисти також узяли на озброєння генеративні нейромережі. Наприклад, сайт новин, афілійований з урядом Китаю, за допомогою ШІ поширював у казахстанському сегменті мережі фейки про «американські біолабораторії в Республіці».

Російські пропагандисти від початку повномасштабного вторгнення в Україну поширювали дипфейки з високопоставленими українськими державними діячами. Найчастіше, мабуть, у таких відео використовують образ Володимира Зеленського — наприклад, у фейку про капітуляцію України або заклику здати Авдіївку.

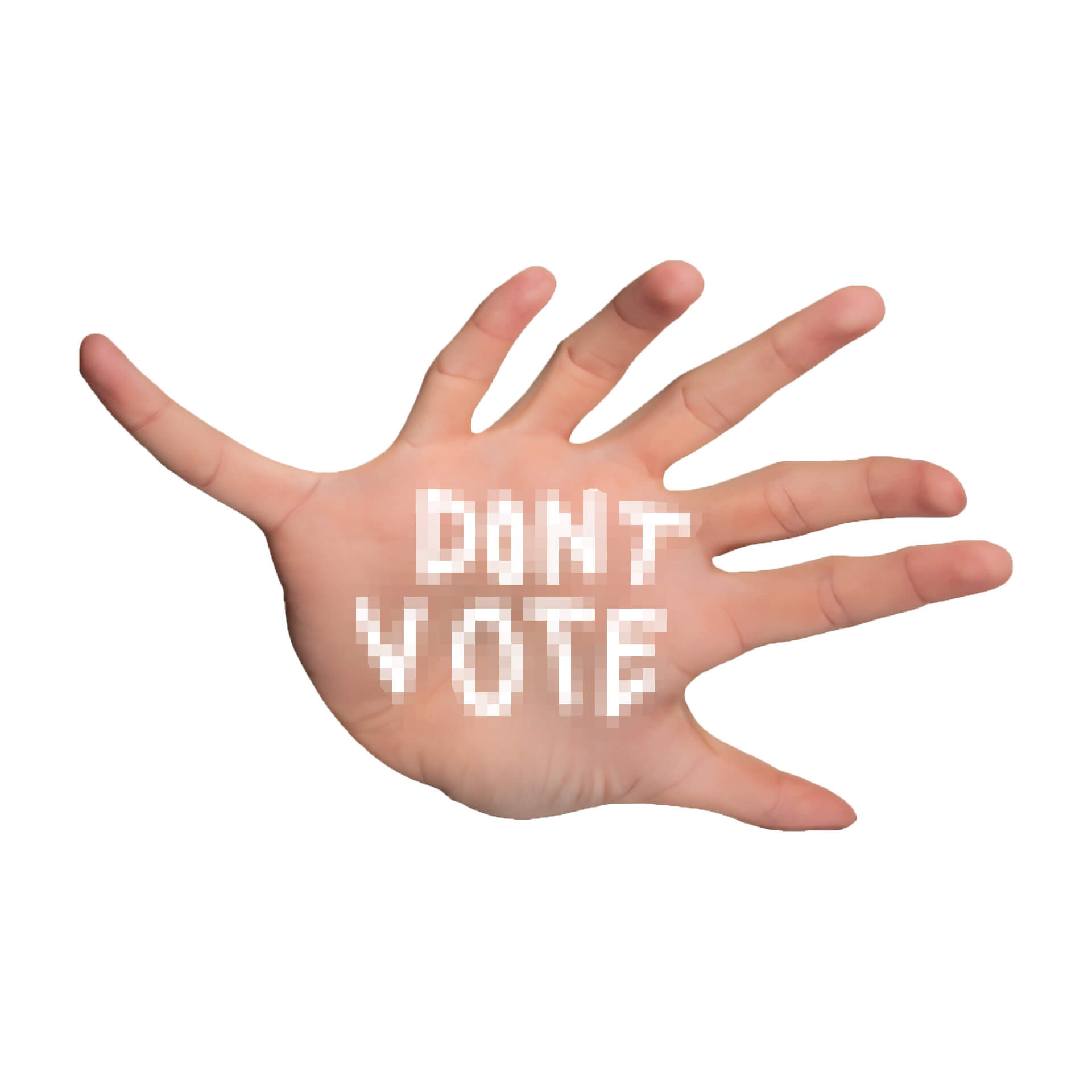

Серйозні побоювання спричиняє вплив згенерованої дезінформації на електоральний процес. 2024 року відбуваються вибори у 50 країнах світу, включно з багатьма європейськими країнами та США. Ми вже спостерігали, як нейромережі використовувалися на виборах у Пакистані, Індонезії, Індії та Словаччині.

Наразі згенерована дезінформація не завдала серйозної шкоди глобальному виборчому процесу. Однак до кінця року ще далеко, і невідомо, як дипфейк-кампанії вплинуть на майбутні вибори.

Колаж: Катерина Круглик / Заборона

Чому ми віримо дипфейкам?

Проблема поширення ШІ-дезінформації полягає навіть не в кількості згенерованих фейків (хоча вона значно зросла за останні кілька років), а в тому, що технології створення підробок стали доступними будь-кому, хто має доступ до інтернету. При цьому самі підробки настільки реалістичні, що визначити їхню штучну природу буває дуже важко без спеціальних навичок та інструментів.

Водночас віральність цих підробок така велика, що навіть при оперативній роботі фактчекерів поширення дезінформації неможливо зупинити. Щобільше, дезінформація впливає на світогляд та рівень довіри до медіа навіть у тих випадках, коли підроблена природа повідомлення стає відомою, і творці фейків, ймовірно, про це чудово знають.

На жаль, когнітивні спотворення, через які люди тримаються за хибну інформацію навіть після її спростування, — не єдина особливість нашої психіки, яка грає на руку розповсюджувачам ШІ-дези.

Вчені з Цюрихського університету в ході експерименту зʼясували, що люди більш схильні вірити фейковим повідомленням, які створені ШІ, аніж тим, що написані людьми. Ймовірно, згенеровані тексти здаються більш правдоподібними через чіткішу структуру і стислість викладу. Зазначимо, що різниця на користь ШІ склала всього 3%, але дослідники, які використовували ChatGPT-3 в експерименті, припускають, що відсоток буде збільшуватися, якщо залучити більш просунуті версії великих мовних моделей.

Ще одну особливість сприйняття дипфейків, схожу на ефект Данінга-Крюгера, виявили вчені з Інституту Макса Планка та Амстердамського університету. Зʼясувалося, що непідготовлені глядачі не відрізняють реальні відео від дипфейків, але при цьому оцінюють свої здібності у розпізнаванні підробок як досить високі. Обтяжувальним чинником є те, що здебільшого учасники приймали фейкові відео за реальні, а не навпаки.

Ефективними засобами для нейтралізації когнітивних спотворень та протистояння дезінформації вважаються інформаційна грамотність та пребанкінг (попередження про можливі маніпуляції, що готуються). «Кампанії з підвищення медіаграмотності вкрай важливі, якщо ми хочемо мінімізувати збитки, яких завдають дипфейки. Якщо навчити аудиторію мислити як фактчекер, можна значно знизити швидкість, з якою широка публіка поширює дезінформацію, та послабити стимул для тих, хто стоїть за її створенням», — вважає Інок Нярікі, менеджер з роботи зі спільнотою в Міжнародній мережі з перевірки фактів Інституту Пойнтера IFCN.

Ідентифікатори ШІ

Програми з виявлення слідів штучного інтелекту у відео, зображеннях або текстах є важливим інструментом. Але для пересічного користувача вони не такі корисні та ефективні, як критичне мислення та уважність.

Сьогодні ідентифікатори залишаються здебільшого професійним інструментом для бізнесу, журналістів та фактчекерів. Багато програм або повністю, або в розширеному функціоналі доступні лише за корпоративною підпискою або за плату. Для такого стану речей є кілька причин.

Розробка якісних, багатофункціональних інструментів для ідентифікації згенерованого контенту потребує ресурсів, тому закономірно, що компанії, які розробляють ідентифікатори ШІ, зацікавлені у монетизації свого продукту. Особливо враховуючи, що інвестори, ймовірно, приділяють технологіям визначення слідів менше уваги, ніж, власне, ШІ-розробкам.

Крім того, отримавши доступ до відкритого інструменту, можна дуже швидко створити програму, яка вмітиме цей інструмент обманювати. Тому розробники змушені шукати компроміс між доступністю та ефективністю свого продукту.

Ще один важливий фактор — для правильного користування програмою та інтерпретації результатів необхідні певні навички та знання. У споживача новин має бути досить висока мотивація, щоб перейти на платну програму для визначення слідів ШІ.

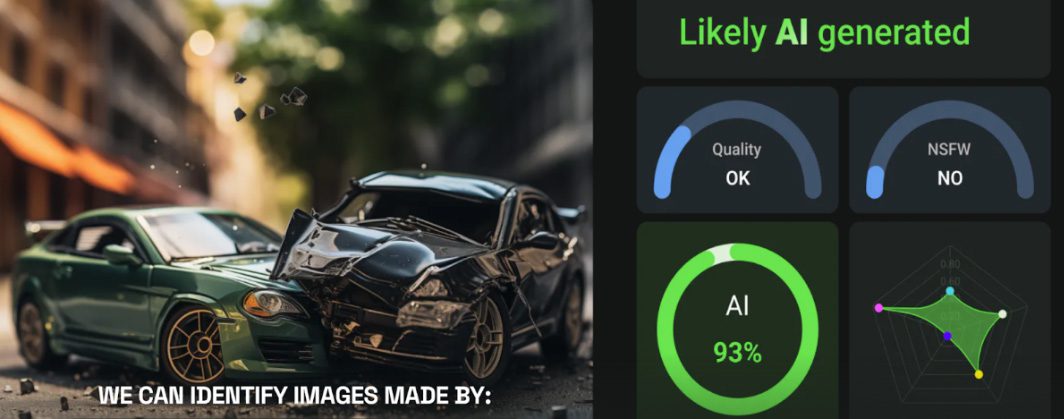

Будь-хто може скористатися такими програмами як Deepware або AI or Not. Але зрозуміти, що означають отримані результати, особливо якщо вони відрізняються в різних програмах, — завдання із зірочкою. У деяких інструментах для виявлення слідів вердикт позначається у відсотках імовірності, а в інших результат виводиться в одній з декількох категорій, наприклад: «швидше за все, створено ШІ» або «швидше за все, створено людиною».

Деякі програми використовують також більш просунуті засоби візуалізації, як-от графіки й «теплові карти», які може бути складно правильно інтерпретувати без додаткової підготовки.

Скриншот: AI or Not

Особливо складно технічним інструментам правильно ідентифікувати згенеровані текст і аудіо. Зокрема, детектори показують різні результати, якщо поміняти місцями абзаци в тексті або відправити на перевірку аудіофайл, який безліч разів звантажували та знову заливали в мережу. Тому для надійного визначення дипфейку варто покладатися не лише на спеціальні програми з ідентифікації, а й на інші інструменти, а також на уважність, критичне мислення і знання маркерів ШІ у різних модальностях.

Як перевіряти на штучний інтелект: інструменти та сервіси

Перераховані нижче детектори перевірені на практиці. Вони доступні, досить зручні та відносно ефективні. Втім, жоден не є бездоганним.

- AI or Not — аналізує зображення та аудіо. З першим, за нашим досвідом, справляється цілком гідно, але з аудіодипфейками працює вже не так упевнено. Безплатна базова перевірка 10 зображень та аудіо доступна після реєстрації, а далі тарифи починаються від $5/місяць.

- undetectable AI — перевіряє текст на сліди ШІ. Показує програми, за допомогою яких, імовірно, був згенерований текст. Доступний без реєстрації. На жаль, схильний давати хибнопозитивні результати.

- DeepFake-o-Meter — аналізує зображення, аудіо та відео. Дозволяє вибрати детектор зі списку доступних варіантів від різних розробників. Є опція не зберігати файли, що перевіряються на сервері, що може бути актуальним, якщо ви працюєте з чутливою інформацією. Інструмент доступний після простої реєстрації.

- Deepware — визначає дипфейк у відео. Можна завантажувати свої файли або перевіряти за посиланням на YouTube, Facebook чи X. Працює як агрегатор — показує результат різних детекторів у відсотках імовірності слідів ШІ. Не завжди видає правдивий середній результат, але непогано справляється з віральними фейками.

- ШІ-класифікатор мовлення від ElevenLabs — розпізнає аудіо, згенероване за допомогою нейромережі. Доступний без реєстрації та обмежень на кількість перевірок. За нашим досвідом, аналізатор справляється непогано, але судячи з того, що програма не розпізнала сліди ШІ у фейковому записі голосу президента США, ефективність детектора може бути не такою постійною.

Інформаційна грамотність

У багатьох віральних відеодипфейках і згенерованих зображеннях підробку можна було визначити неозброєним оком. Серед таких фейків:

- фотографії президента Франції Еммануеля Макрона — нібито під час заворушень у Парижі;

- фейк із Дональдом Трампом нібито в оточенні його темношкірих прихильників;

- відеофейк інтервʼю секретаря РНБО України Олексія Данилова, де той нібито підтверджує причетність України до теракту у московському «Крокус-Сіті Голлі».

Причина, з якої ці повідомлення поширилися, полягає не у високій якості фейків, а в неуважності глядачів, їхній схильності шукати підтвердження своєї думки та ділитися сенсаційними новинами, не перевіряючи їхньої правдивості. Творці фейків знають про ці слабкості нашого сприйняття і розраховують на швидке поширення фейків, якому не перешкоджає навіть їхня сумнівна якість.

І тут знову допоможе інформаційна грамотність. Достатньо дотримуватися кількох простих правил:

- Уважно вивчіть матеріал, яким ви маєте намір поділитися, звертаючи увагу на деталі зображення. Можна пропустити такі явні маркери ШІ, як зайва рука на зображенні або неприродна міміка людини на відео, якщо переглядати новину поверхово.

- Переконайтеся, що джерела повідомлення заслуговують на довіру.

- Не лінуйтеся та користуйтеся методом латерального читання, щоб перевірити інформацію ще раз — можливо, фактчекери вже спростували її.

Колаж: Катерина Круглик / Заборона

Заходи з контролю ШІ з боку соцмереж

Правові рамки використання генеративного штучного інтелекту як усередині країн, так і на міжнародному рівні ще тільки встановлюються, а їхню ефективність буде видно лише з часом.

На жаль, чинне законодавство не перешкоджає розповсюдженню фейків, а скоріше діє реактивно. При цьому аналітики зі сфер економіки та IT припускають, що ефективність будь-яких заходів з контролю завжди відставатиме від розвитку технологій.

Але це не означає, що ШІ-сферу не слід регулювати. Експерти з Google кажуть: «ШІ — надто важлива [технологія], щоб її не регулювати, і надто важлива, щоб не регулювати добре».

IT-фахівець і директор організації «Товариства захисту інтернету» Михайло Клімарьов вважає, що технічно обмежити розповсюдження згенерованої нейромережами дезінформації неможливо, як і притягнути до відповідальності творців фейків. Адже часто вони перебувають за межами тих країн, де поширюють дезінформацію. Однак можна законодавчо зобовʼязати компанії стежити за якістю відомостей, що поширюються на їхніх платформах або за допомогою підконтрольних їм технологій.

Основні гравці на ринку соцмереж — наприклад X, YouTube, Facebook і TikTok, — вже сформували низку заходів щодо контролю над згенерованим або зміненим контентом. У лютому Google, OpenAI, TikTok, Meta й Microsoft представили чорнову версію угоди щодо спільної розробки заходів протидії «передвиборчій дезінформації, створеній штучним інтелектом».

На початку весни 2024 року Мета і YouTube вже оголосили про розширення правил маркування згенерованого контенту, а Google заблокував користувачам можливість ставити питання на тему виборів у своєму чаті Gemini.

Національні закони та стратегії щодо штучного інтелекту

Один із перших законодавчих актів, побічно повʼязаних із роботою штучного інтелекту, зʼявився в Південній Кореї 2008 року, тобто задовго до гучної появи генеративних моделей. Документ був спрямований на регулювання розвитку та поширення «розумних роботів». Настанови та правила для контролю технологій ШІ, що застосовуються у різних сферах, поступово зʼявлялися і в інших країнах.

Першою країною, яка опублікувала Національну стратегію розвитку штучного інтелекту, стала Канада. Документ містять чотири цілі для досягнення та програми реалізації. З них випливає, що пріоритетом для канадців є підтримка досліджень і талантів.

Майже одночасно прийняв свій «План розвитку штучного інтелекту нового покоління» Китай. Це найбільший і всеосяжний проєкт роботи з ШІ. Автори звертають увагу на те, що розвиток штучного інтелекту може загрожувати безпеці, і це необхідно враховувати.

У 2018 році у Китаї зʼявилася «Біла книга зі стандартизації ШІ». Крім ініціатив щодо впровадження та управління ним, документ також висвітлює питання надійності та безпеки. Таким чином у сфері, з одного боку, реалізовуються проєкти з масштабування та розвитку, а з іншого — з оцінки та регулювання.

2020 року міжнародне агентство HolonIQ повідомило про 50 національних стратегій у галузі штучного інтелекту. Тоді ж була офіційно запущена Обсерваторія політики ОЕСР щодо ШІ — Обсерваторія Організації економічного співробітництва та розвитку (ОЕСР) щодо політики в галузі штучного інтелекту. На цю мить OECD AI надала дані про більш ніж 1000 політичних ініціатив щодо ШІ у 69 країнах світу. 354 з них спрямовані на керівництво та регулювання в галузі, проте основна частина має загальний рекомендаційний характер.

Колаж: Катерина Круглик / Заборона

Євросоюз: AI act як модельний закон

Найбільше, судячи з усього, у сфері правового врегулювання роботи штучного інтелекту нерекомендаційного типу домігся Євросоюз.

У 2019 році Єврокомісія опублікувала досьє «Зміцнення довіри до людиноорієнтованого штучного інтелекту». У ньому перераховані рекомендації щодо створення ШІ, що заслуговує на довіру. Ключові вимоги, яким мають відповідати такі додатки:

- людська активність та нагляд;

- технічна надійність та безпека;

- конфіденційність та управління даними;

- прозорість;

- різноманітність, недискримінація та справедливість;

- соціальний та екологічний добробут;

- підзвітність.

У грудні 2023 року країни ЄС та Європейський парламент досягли угоди щодо закону про штучний інтелект. У березні 2024 року закон, відомий як AI act, був ухвалений Європарламентом. Вже зараз його називають знаковим і таким, що стане відправною точкою для нової моделі управління, побудованої на технологіях. Він спрямований на класифікацію та регулювання додатків та поділяє їх на чотири категорії залежно від рівня ризику, який вони несуть. Деякі системи будуть повністю заборонені — наприклад, частина з тих, що стежать за людьми в режимі реального часу.

Також у документі зазначено, що штучні чи оброблені зображення, аудіо- або відеоконтент мають бути чітко позначені як такі.

Регуляція штучного інтелекту в США

Вартий уваги і підписаний 2023 року Указ про розробку та використання штучного інтелекту, який встановлює нові стандарти безпеки та захисту ШІ. Серед його пунктів є такі:

- розробники систем ШІ, що становлять загрозу національній безпеці США, економіці, здоровʼю населення або безпеці, повинні надавати уряду результати випробувань на безпеку;

- Міністерство національної безпеки має створити спеціальну Раду з безпеки ШІ та разом із Міністерством енергетики протистояти загрозам, повʼязаним зі штучним інтелектом/кібербезпекою, а також хімічним біологічним, радіологічним та ядерним ризикам;

- для захисту від шахрайства Міністерство торгівлі розробить посібник з автентифікації контенту та нанесення водяних знаків для чіткого маркування контенту, створеного штучним інтелектом.

На початку лютого 2024 року уряд США запровадив заборону на роботизовані дзвінки, які використовують згенеровані голоси. Приводом стала подія у штаті Нью-Гемпшир. Місцевим жителям стали масово надходити дзвінки нібито від президента Джо Байдена. Згенерований голос президента закликав своїх прихильників не голосувати на президентських виборах.

Технологічні Казахстан та Україна

У Казахстані поки що немає спеціальних законів, спрямованих на контроль за створенням та роботою ШІ. Усі національні ініціативи, відзначені OECD AI, поки що спрямовані лише на сприяння розвитку проєктів, повʼязаних зі штучним інтелектом.

Про необхідність правового регулювання ШІ та робототехніки заявлено в Концепції правової політики Республіки Казахстан до 2030 року. Основними питаннями законотворці вважають розподіл відповідальності за шкоду, заподіяну ШІ та роботами, а також визначення належності права інтелектуальної власності на твори, створені за їхньої участі.

В Україні схожа ситуація. Наприкінці грудня 2020 року Кабінет міністрів схвалив Концепцію розвитку штучного інтелекту в Україні до 2030 року. А в жовтні 2023-го Міністерство цифрової трансформації оприлюднило дорожню карту з регулювання ШІ. В імплементації обіцяють bottom-up підхід, який спочатку передбачає надання бізнесу інструментів для підготовки до майбутніх вимог, а закон буде ухвалено вже після цього.